文 / 华为DCS解决方案首席架构师 葛建壮

AI大模型的大爆发,为千行百业的创新带来了新的机遇,甚至可能会重构企业业务和产品,为部分企业带来弯道超车的机会。同时业内大模型厂家众多,已经进入“百模大战”阶段,企业如何选择让人眼花缭乱的大模型,以及如何实施大模型战略遇到了较多的挑战。

首先,大模型众多选择难:如何选择适合自己业务需求的大模型?业内主流的NLP大模型相对比较成熟,多模态大模型在持续发展,但是总体成熟度不足,所以可优先尝试采用具有相关行业案例的NLP大模型进行智能客服、景区导览、政策问答等以自然语言交互为主的场景方案,CV和语音等多模态大模型方案可按需进行。对于业务数据安全性不高,特定行业场景需求不强烈,并且只是基于大模型结果进行业务应用开发的场景,可选择云上大模型API方式(例如OpenAI)开发新业务。如果业务数据属于企业隐私数据,并且通用大模型无法直接满足业务需求,则需要结合企业行业和私有业务数据进行进一步调优,此场景建议在企业内部本地部署大模型,根据企业私有数据进行Fine Tuning后再开发AI大模型应用。在企业内部部署大模型场景下,可能需要多家大模型反复对比才能评估出可用模型,所以一套开放的适用于多种大模型部署的高性能的基础设施底座成为企业降低大模型部署成本和试错的重要参考项,预先优化的AI大模型一体机成为重要选项。

其次,AI大模型的快速部署和运维难是第2个挑战:大模型良好运行依赖计算、存储、网络等的深度协同设计和联合优化,AI全栈硬件和软件众多,形成较为厚重的技术栈,单点的故障都会导致大模型业务中断或性能下降,传统的组合式或拼凑式部署模式会导致计算、存储、网络很难进行协同优化,无法满足企业快速交付周期和降低运维难度的诉求,预先调优的全栈式AI大模型一体机为问题的解决带来可能。

再次,AI大模型精调对数据使用效率和存储性能的挑战:大模型厂家的通用大模型(L0大模型)在客户现场需要根据企业行业数据进行精调,打造行业大模型(L1大模型),各个业务部门可根据进一步的细化部门业务数据精调细分场景大模型(L2大模型),行业数据和业务部门数据需要被收集、清洗、预处理等操作,然后才能被大模型精调使用,传统方式此类数据会单独存储,单独处理,然后再拷贝到训练集群,数据多次拷贝会导致数据处理周期长、数据一致性难保证,所以数据预处理平台和训练平台需要能共享数据,提升数据使用效率。精调训练过程需要多机多卡协同,需要训练数据多机间共享,并且训练数据主要是小文件,小文件存储性能对训练效率产生较大的影响,同时AI大模型训练周期长,易于中断,所以大模型训练中会频繁通过Checkpoint保存中间训练状态和结果,当训练中断时,不论是模型参数问题还是硬件故障,及时通过共享保存的Checkpoint恢复训练,所以高性能的可靠共享存储是关键指标之一。

L2模型在推理场景的持续更新是大模型落地的第4个挑战:L2大模型精调完毕后,配合应用软件在端侧业务场景快速部署进行推理,端侧需要提升运维效率,实现免入站运维,并能够根据企业中心L2大模型的逐步调优灵活更新,所以L2大模型和应用在端侧业务部署时,如何能快速部署,如何能够和企业中心的最新L2大模型进行协同更新成为关键挑战,支持边云协同、支持模型升级业务0中断和软硬一体的大模型推理一体机成为最佳选择。

模型全链路安全是大模型在企业落地的第5个挑战:大模型是大模型公司和企业客户的核心资产,当大模型公司的模型交付给企业过程中L0模型的全链路安全性,以及企业根据大模型精调后的包含了企业机密信息的L1和L2大模型的全链路安全性必须统一设计和考虑,防止大模型被无序复制和滥用,需要企业端到端设计大模型的安全资产管理机制和安全管理模型。

综上,大模型在企业中的部署任重而道远,预先调优的、开放的、预制计算/存储/网络/全栈管理软件/大模型开发工具链/大模型、支持端侧模型平滑更新的AI全栈一体机是最佳选择。

一、 大模型在企业内部部署推荐一体机模式

大模型训练对网络、存储等有特定要求,例如参数网络一般需要200G或400G带宽网络,海量小文件训练需要共享存储和高IOPS读写,同时Checkpoint也需要高IOPS读写,普通云平台中的通用存储和通用网络无法满足训练需求,所以企业常规建设的标准的云平台模式无法适应大模型的部署要求,独立部署大模型基础设施是目前较为最优的方式,通过独立的经过调优的大模型一体机方式进行部署和交付,并可根据需要平滑扩容是推荐方案。

1. 全栈一体机方式部署大模型提升了交付效率,降低了维护成本,提升了大模型业务开发效率

散件组合构建AI大模型基础设施方案是一种可选选择,但是带来了众多的挑战

a. 交付周期长,管理复杂:散件组合基础设施方案,需要独立采购计算、存储、网络、机柜等,到货周期长,每种设备独立管理,运维复杂,需要现场组装部署,进行现场设备组网调优、大模型与设备的配合调优,导致交付周期长,交付成本高昂。

b. 对机房能耗和空间规划影响大:设备型号不归一,能耗不定,机房供电和制冷均需要按照大模型需要的设备功耗和散热进行设计,功耗的不确定性和空间的不确定性会导致机房供电、空间设计和能耗的极大浪费。

通过全栈一体机方式,出厂即将计算、存储、网络、机柜进行了综合调优,设备确定,算力确定,存储能力确定,网络带宽确定、功耗确定、机房占用空间确定,自带高可靠保证,全栈硬件统一监控管理,机房电力改造和散热可直接评估,大大加速大模型的部署和运维效率。一体机方案解决了大模型的部署和运维问题,企业可花费更多的时间在大模型业务创新上,提升创新效率。

2. 一体机需要开放,兼容多家大模型,降低基础设施构建成本

企业在选型测试阶段以及后续业务发展需要多种大模型能力,可能会引入多家大模型厂家,不同的类型大模型如果采购不一样的基础设施,均要单独调优,导致运维和采购成本急剧增加,开放的一体机通过总结大模型本质需求(网络、存储、算力、资源调度和管理需求),进行深度调优,同时支持多家大模型在此环境部署,降低企业采购成本和运维成本。

3. 企业需要三种大模型一体机支撑企业大模型落地

a. 训练一体机:对于数据变化频繁,持续追求模型精度提升、训练动作频繁的场景,企业根据采购的L0大模型或已经精调的L1大模型,持续根据新数据训练L1或L2大模型,此时需要具备强悍算力的大模型训练一体机,可按需扩展存储和算力。此场景需要高性能参数训练网络(200G/400G/更高),需要高性能小文件访问能力的共享文件存储和大量GPU/NPU AI卡。

b. 推理一体机:此场景在企业中使用频率最高,是大模型在企业落地的主要形式,浓缩或裁剪后的大模型与AI应用联合部署,为最终客户业务服务,一般大模型由于参数较大(百亿、千亿等),通畅需要多卡联合推理,所以高密GPU/NPU算力成为关键需求,算力的统一智能高效调度和高密算力池化是提升推理机运行效率的关键能力。

c. 训推一体机:对于以推理为主,但是周期性会进行少量训练的场景,需要通过容器平台,按照指定SLA动态调度CPU和GPU资源,优先保证推理。同时在此场景中,常用的GPU直通或VGPU方案在训练中,大量的AI算力损失在故障、调度、时间片浪费、空间单元浪费等环节,真正的算力利用率不到 30%,所以更高效的GPU池化技术,训练和推理进程按需共享混合部署,支持按照SLA调度,提升GPU资源利用率,从而减低训推成本。

二、 需要制定明确的大模型训推安全规范,确保大模型资产安全

大模型本质上是一个数据库,其存储了被训练的所有材料,所以企业经过行业数据和部门数据精调过的模型,包含了企业各种敏感数据,如果泄露,则会给企业造成严重的后果。所以需要对模型的全链路进行安全管理。

1. 训练数据安全

训练数据是企业核心数据,在训练数据采集、清洗、预处理等环节确保数据按需授权、按需访问、可控访问、适当脱敏,严格控制训练数据的扩散。

2. 大模型共享安全

大模型共享发布后,如何控制只有被授权方可访问和使用大模型,防止大模型被非法复制、破解和使用。并且在模型发布供应链中,防止攻击者篡改模型。所以模型在发布和使用过程中,需要通过资产完整性保护和资产加密构建安全可信的大模型共享能力,保障AI资产安全运行

1) 资产完整性保护:对发布资产分别进行内外层数字签名,用于一线服务/客户对资产进行完整性校验,保证资产安全应用;

2)资产加密:通过白盒加解密表和本地秘钥,保障AI资产安全、不被恶意窃取盗用;

同时L0大模型内涵数据一般为通用数据,企业数据由于涉及安全隐患,一般不可能提供给大模型厂家进行训练,所以在企业内部,大模型的使用通常结合2种方式来进行部署:a.将行业数据和部门数据作为深入,对L0大模型进行精调 b.由于大模型从训练完成到使用时往往有数月的滞后性,所以可结合L2大模型+向量数据库,通过向量数据库提供L2模型精调后的最新信息,所以向量数据库也需要确保数据隐私的可控访问和使用。

3. 推理数据安全

L2大模型训练完毕后,在实际应用中,客户端应用使用企业业务机密信息与大模型进行交互推理,其上传的信息可能包含了敏感业务信息,大模型推理端会记录此类信息作为交互上下文,其推理信息需要安全保存和控制访问,并制定定期清除策略,防止敏感信息的泄露。

4. 大模型应用安全

大模型应用可直接访问大模型,所以应用本身是大模型安全的关键入口之一,可通过安全容器和安全启动,将应用隔离在具有高安全性和可靠性的隔离域中,结合容器安全检测,确保应用本身不会成为攻击入口,从而保证数据和模型安全。

三、 训练&训推一体机与边缘推理一体机协同周期更新L2大模型,提升客户体验

训练&训推一体机周期性根据企业收集的最新数据更新L2大模型,提升业务推理精度和准确度,L2模型重新训练完毕后,需要通过工具链将新模型同步至边缘推理一体机,在边缘推理一体机通过自动更新/滚动升级、增量升级等方式进行升级,并实现升级过程大模型业务不中断。

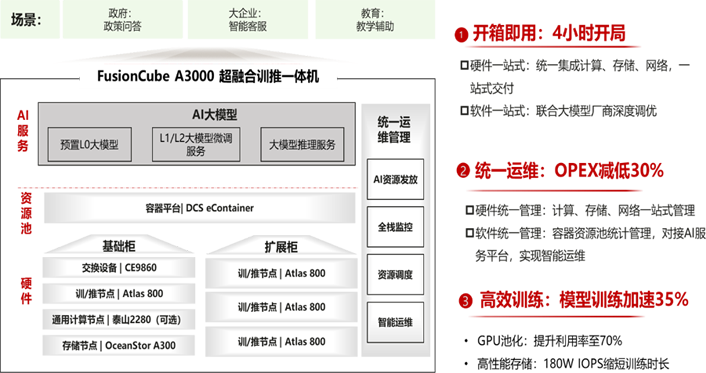

四、 华为FusionCube A3000训推一体机助力企业大模型最后一公里落地

华为一体机FusionCube A3000为企业客户提供了训练一体机、训推一体机和推理一体机三种形态,并且与部分大模型厂家联合出厂内置L0大模型和大模型开发工具链,在企业侧聚焦为客户提供L1和L2大模型场景,为企业提供开箱即用的大模型AI平台,为企业AI大模型创新提供了坚实的底座。

FusionCube A3000出厂预制高性能训推节点服务器、高性能共享存储、最高400G的AI网络设备和一体化机柜,并且全栈硬件通过管理软件MetaVision统一进行管理和监控,一键定位问题,分钟级故障修复。

1. 高性能训推服务器节点

单台服务器可支持华为昇腾8卡910模组,FP16算力达到2.5PFLOPS,也可支持8卡H800英伟达模组,FP16算力可达15.8PFLOS,并且可平滑扩展到16个节点支持128卡,充沛的算力可满足多种场景需求。

2. 高性能共享存储

采用标准文件接口,支持未来扩展至多种训练平台开放对接.提供大容量、共享访问,性能持平本地盘的存储能力.提供异地数据同步能力

a. 支持直通GPU( NFS over RDMA ):训练数据加载时间缩短百倍至ms级,提升2~8倍的数据传输带宽,减少训练服务器内存与GPU的交互,效率更佳

b. 高性能:多条链路聚合和客户端数据缓存,实现单流加速,性能提升4~6倍,链路故障秒级自动切换;基于OceanStor Dorado架构的FlashLink稳定时延、DTOE协议卸载、元数据智能缓存实现领先的企业NAS性能,实现亚毫秒级低时延

c. 高效训练:多级均衡技术,加速小文件场景性能,存储单节点IOPS可达180W IOPS,存储单节点带宽可达50GB/S。

3. 高性能参数网络

l 高密度400GE/100GE/40GE汇聚,容量超群;

l 全网高可靠,故障场景业务无感知

l 智能无损网络,满足RoCEv2应用高性能需求

l 设备零配置部署,自动运维

4. 一站式开发大模型开发工具链

l 覆盖数据采集、标注、清洗、加工的一站式数据管理中心,为AI模型开发提供所需高质量数据

l 灵活对接多类数据源,支持多模态数据接入和可视化管理,支持便捷的数据导入、导出、查看、分版本管理、权限控制

l 内置丰富的数据预处理算法,如图像的增强、去重、裁剪,视频的均匀抽帧等数据加工服务

l 使用大模型开放服务平台提供的微调开发工具链,仅需准备少量行业数据和简单的步骤,即可在平台上训练并部署用户的专属模型

FusionCube A3000超融合一体机,全栈模块化设计,整柜交付,开箱即用,内置AI大模型,重塑产业格局,助力AI应用高质量发展。

转载

转载